20 слов, которые пишут неправильно даже грамотные люди

30 января 2021 Образование

Новая порция грамотности с лайфхаками, которые помогут запомнить все сложные случаи.

1. Навскидку

Неправильно: на вскидку.

Так и подбивает разделить слово на две части, но это ошибка. Оно отвечает на вопрос «Как?» и является наречием, потому пишется слитно. Но легче запомнить по синонимам, которые раздельно писаться не могут: примерно, произвольно.

2. Абонемент

Неправильно: абонимент.

Почему‑то то тут, то там предлагают купить «абонимент». Действительно, в слове слышится злосчастная «и». Проверить написание никак нельзя, потому что лексема словарная. Но запомнить можно, если подобрать пароним‑рифму с буквой «е» — абонент. В обоих случаях букве «и» не место.

3. Следующий

Неправильно: следущий.

Сложность возникает, потому что в устной речи букву «ю» не слышно. Чтобы не допустить ошибку, просто про себя проговаривайте: «Я следую — значит, следующий».

4. Будущий

Неправильно: будующий.

По тому же принципу, что и выше, легко запомнить написание этого слова: «Я буду — значит, будущий».

5. Кардинальный

Неправильно: кординальный, координальный.

Какие только варианты этого слова ни видел интернет, даже с удвоенной «о» в начале. Но раз и навсегда запомнить, как оно пишется, поможет «Этимологический словарь русского языка» Макса Фасмера. «Кардинальный» происходит от латинского слова cardinālis, что значит «главный». Буква «а» пишется и в том, и в другом случае.

6. Бойкотировать

Неправильно: байкотировать.

На слух буква «о» в этом слове не воспринимается, отсюда и все проблемы. Понять, почему оно всё-таки пишется иначе, можно из его происхождения. Мы позаимствовали слово из английского языка, в который оно вошло благодаря ирландскому управляющему имением Чарльзу Бойкоту (Charles Cunningham Boycott). Он был слишком требовательным, и в 1880 году земельные арендаторы отказались ему платить, объявив бойкот. Человек получил нелестную славу, а мы — букву «о» в этом слове.

Человек получил нелестную славу, а мы — букву «о» в этом слове.

7. Гран‑при

Неправильно: гранпри, гран при, гранд‑при.

Для тех, кто знает французский язык, дефис может показаться здесь лишним. И даже ненужная «д» норовит затесаться. Потому что в оригинале выглядит оно так: grand prix. Но в данном случае заимствованное слово имеет два корня: -Гран- и -при-. В иностранном языке каждый из них может существовать самостоятельно, в русском Гран‑при является сложным словом. Потому что составлено из двух корней, и между ними дефис необходим.

8. Линолеум

Неправильно: ленолиум, ленолеум, линолиум.

Бедное напольное покрытие страдает на письме, кажется, с момента своего создания. К сожалению, проверить правильность написания никак нельзя. Но давайте обратимся к первоначальному составу линолеума, он кроется в самом названии. С латинского linum переводится как «лён», а oleum — «масло». Соединив эти два слова, мы получаем единственно верное написание.

9. Малозаметный

Неправильно: мало заметный.

Очень хочется разбить слово на две части, и это даже объяснимо: здесь два корня — -мал- и -замет-. Но тогда встаёт вопрос, откуда там взялась буква «о». Всё очень просто: она является интерфиксом и как раз соединяет два корня, делая слово сложным. Потому и писать мы будем его слитно, как и другие составные прилагательные.

10. Квинтэссенция

Неправильно: квинтессенция, квинтесенция.

Блеснуть знаниями и ввернуть умное словечко порой очень хочется, но на письме легко получить обратный эффект. Однако стоит нам разбить лексему на две части, как всё встаёт на свои места. С латинского quinta essentia переводится как «пятая сущность». Слово «эссенция» вам тоже наверняка знакомо, и «э» в начале отлично слышится. Только вот удвоенную «с» придётся запомнить, проверить её никак нельзя.

11. Периферия

Неправильно: переферия.

Русская приставка пере- так и просит появиться в этом слове, но на самом деле -перифери- является корнем. Не допустить ошибку нам поможет история его возникновения. Происходит слово от греческого periphereia — окружность, где peri значит «вокруг».

Не допустить ошибку нам поможет история его возникновения. Происходит слово от греческого periphereia — окружность, где peri значит «вокруг».

12. Предыстория

Неправильно: предистория.

В русском языке существует простое правило. Если приставка заканчивается на согласную, а слово начинается на «и», то между ними ставится «ы». Пример, в котором это явно слышится, — «подыскать», но «поискать».

13. Заведующий

Неправильно: заведущий.

И снова коварная буква «ю» при произношении теряется. Но мы находим её тем же лёгким способом, что и выше: «Я заведую — значит, заведующий».

14. Холестерин

Неправильно: холистерин.

Как и с большинством не родных нашему языку слов, с ним возникают сложности. Холестерин — это особенное жирное вещество, содержащееся в желчи. Происхождение у слова греческое, и chole как раз и значит «желчь». В русском же -холе- является одним из корней.

В русском же -холе- является одним из корней.

15. Инцидент

Неправильно: инцедент.

Это обрусевшее иностранное слово целиком является корнем. Оно словарное, и его надо запомнить. Но на выручку нам снова приходит этимология. Слово произошло от латинского incidentis — случающийся. И в том, и в другом случае пишем «и».

16. Ингредиент

Неправильно: ингридиент, ингредеент.

Сложное заимствованное словарное слово, которое тоже целиком представляет собой корень. С «е» в начале ошибки редко, но встречаются. Основная сложность кроется в середине. Чтобы писать правильно, снова обратимся к латинскому языку. Ingredi в переводе значит «входить». Потому ингредиент — это составная часть чего‑либо, то есть входящая в состав.

17. Какофония

Неправильно: кокофония.

Вы неоднократно сталкивались с этим явлением, когда соседский ребёнок учился играть на пианино или кто‑то поблизости делал ремонт. А вот как писать слово правильно — знают не многие. Запомнить, почему пишется «а», нам поможет греческий язык. В его составе есть слово kakos, в переводе — дурной, плохой. В принципе, оно и верно — приятные звуки kakos не назовут.

А вот как писать слово правильно — знают не многие. Запомнить, почему пишется «а», нам поможет греческий язык. В его составе есть слово kakos, в переводе — дурной, плохой. В принципе, оно и верно — приятные звуки kakos не назовут.

18. Канапе

Неправильно: канапэ.

Это французское слово — canapé — означает не только маленький бутерброд, но ещё и широкое кресло или диванчик. Как мебель стала маленькими бутербродами — история умалчивает. Зато известно, что в слове часто допускают ошибку.

19. Чрезмерный

Неправильно: черезмерный.

Лишняя буква «е» напрашивается, потому что мы привыкли видеть слово «через» в качестве предлога. Оно и встречается чаще, и значение имеет такое же. Но в данном случае чрез- является приставкой. Она существовала ещё в старославянском языке и выглядела как «чрѣзъ». С тех пор слово «чрезмерный» так и пишется, и это надо запомнить.

20. Экстремальный

Неправильно: экстримальный.

В заблуждение многих вводит слово «экстрим», в котором употребляется «и». Запомнить, как пишется каверзное прилагательное, нам поможет мороженое. Если помните, есть такой рожок — Extreme. Вспоминая его, вы точно не допустите ошибку.

Читайте также 🧐

- 44 слова, которые мы употребляем неправильно

- Экспресс-тест: найдите слова, в которых нет ошибок!

- 40 заимствований в русском языке, которые бесят читателей Лайфхакера

как правильно пишется слитно или раздельно по правилам русского языка

В этой статье, ссылаясь на правила русского языка, мы разберём, как правильно пишется наречие: «вполне» или «в полне». Выполним тест и сохраним верное написание слова в памяти

Выполним тест и сохраним верное написание слова в памяти

Владислав Юмагулов

Автор КП

Анна Татьянина

Учитель русского языка, литературы и риторики гимназии №12 города Саранска

С вопросом, как пишется «вполне», встречался практически каждый. Чтобы в этом разобраться, необходимо определить, какая перед нами часть речи, а затем разобрать слово по составу. Уделите этой статье 5 минут, и вы больше никогда не столкнетесь с проблемой в написании слова. В конце эксперт расскажет нам о секретных методах, как запомнить, слитно или раздельно пишется «вполне», а затем мы закрепим наши знания тестом.

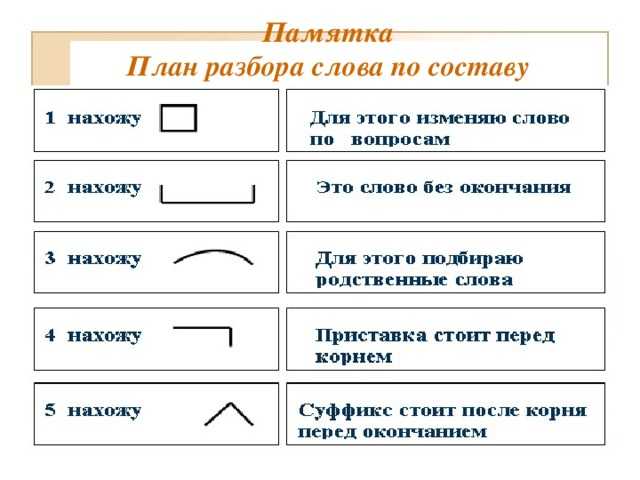

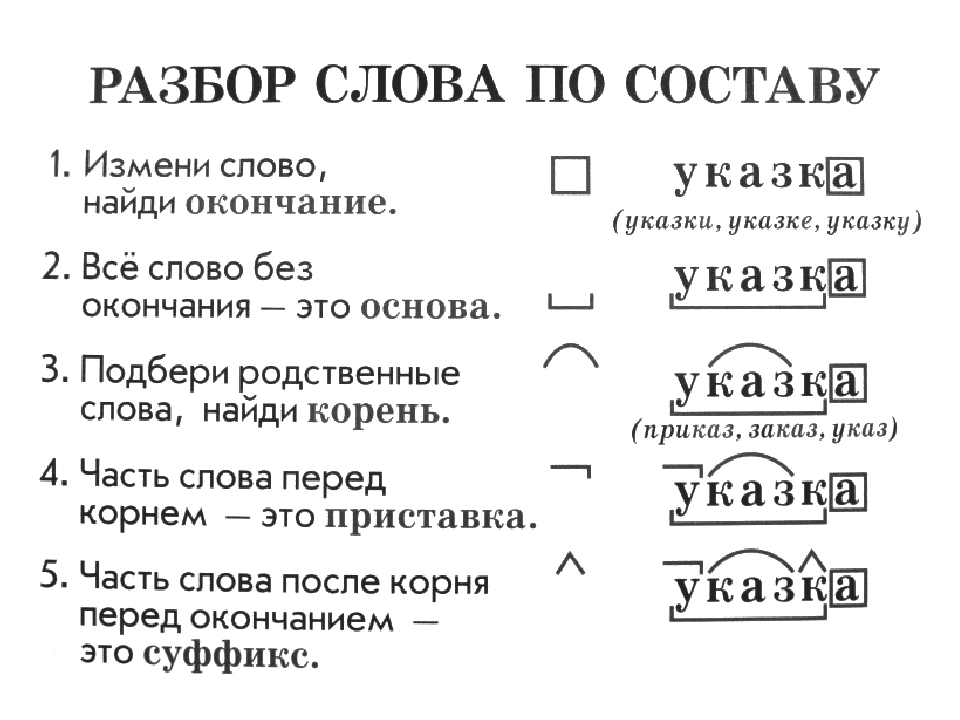

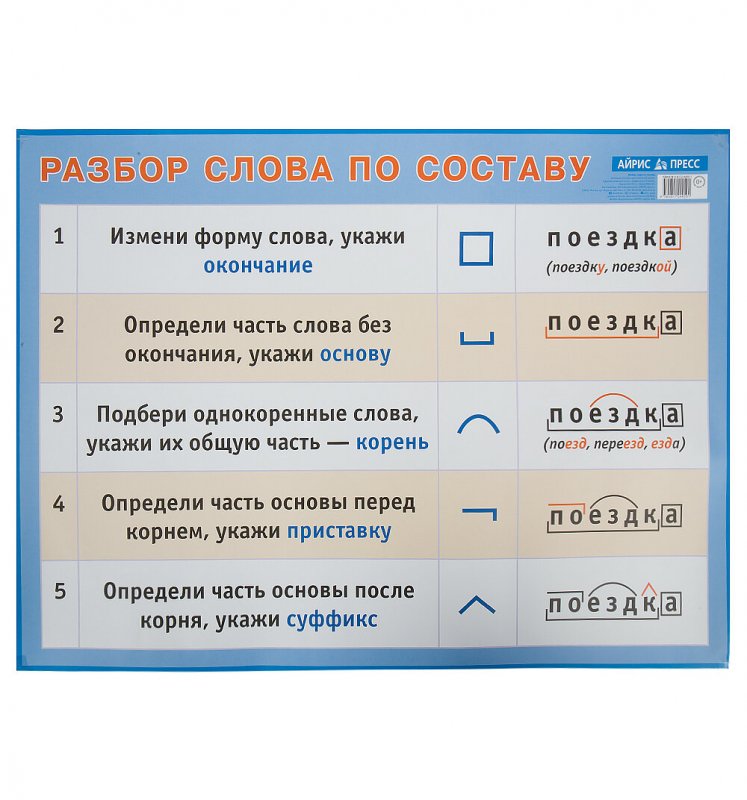

Правило «вполне»

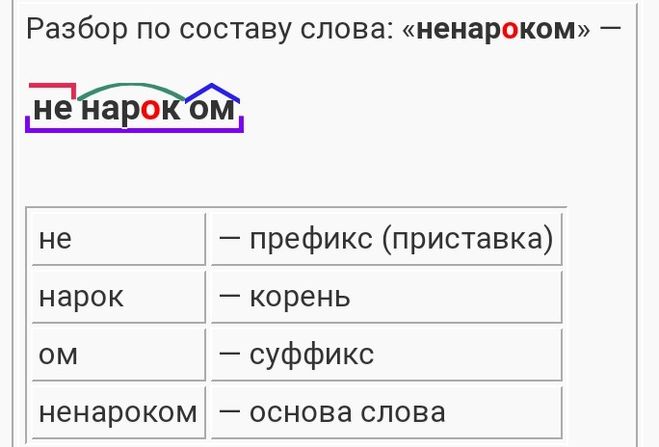

К слову «вполне» можно задать вопрос: «как?». Таким образом, мы приходим к выводу, что перед нами наречие, где «в-» — приставка, «-полн-» — корень, «-е» — суффикс. Оно образовалось от прилагательного «полный». А теперь вспомним школьное правило: наречия, образованные от прилагательных приставочно-суффиксальным способом, пишутся слитно. Слов «в полне», а также «в-полне» в русском языке нет.

А теперь вспомним школьное правило: наречия, образованные от прилагательных приставочно-суффиксальным способом, пишутся слитно. Слов «в полне», а также «в-полне» в русском языке нет.

В ТЕМУ

Примеры

На улице дождь, день для пляжного отдыха не вполне подходящий.

Да, он решил сделать это, но его вполне можно понять.

Это вполне возможно, если ты действительно этого хочешь.

Мне должны дать премию на работе, и это вполне реально, если я сдам материал вовремя.

Я был вполне уверен в том, что говорил.

Советы преподавателя

Анна Татьянина, учитель русского языка, литературы и риторики гимназии №12 города Саранска:

— Ответить на вопрос, как пишется «вполне», несложно. Из курса начальной школы известно: любой предлог пишется раздельно со следующим словом, если между ними можно вставить ещё одно слово. Возможно ли это в нашем случае? Нет, ведь не существует слова «полне», нельзя сказать «в большом полне». Следовательно, «вполне» пишется слитно, так как это наречие, отвечающее на вопросы «как?» или «каким образом?».

Из курса начальной школы известно: любой предлог пишется раздельно со следующим словом, если между ними можно вставить ещё одно слово. Возможно ли это в нашем случае? Нет, ведь не существует слова «полне», нельзя сказать «в большом полне». Следовательно, «вполне» пишется слитно, так как это наречие, отвечающее на вопросы «как?» или «каким образом?».

Для запоминания можно использовать следующую рифмовку:

Ясно всем ― тебе и мне:

Слитно пишется «вполне».

Проверьте себя

Наш традиционный тест поможет закрепить полученные знания.

| Пройти тест |

В полне

Вполне

В-полне

| Дальше |

| Проверить |

| Узнать результат |

Прилагательное

Местоимение

Наречие

| Дальше |

| Проверить |

| Узнать результат |

Предлогом

Приставкой

Часть корня

| Дальше |

| Проверить |

| Узнать результат |

Вполне возможно, что мы уедем завтра

Это не в полне подходящий пример

Я вполне доволен тем, что получилось

| Дальше |

| Проверить |

| Узнать результат |

Вполне

В полне

В-полне

| Дальше |

| Проверить |

| Узнать результат |

Наречия, образованные от прилагательных приставочно-суффиксальным способом, пишутся слитно

Наречия, образованные от прилагательных приставочно-суффиксальным способом, пишутся раздельно

Наречия, образованные от прилагательных приставочно-суффиксальным способом, пишутся через тире

| Дальше |

| Проверить |

| Узнать результат |

Трактор в полне может здесь проехать

Мотивы преступников вполне понятны

В обоих случаях суть в полне очевидна

| Дальше |

| Проверить |

| Узнать результат |

0-3 — Повторите теорию и вернитесь к тесту!

| Пройти еще раз |

4-5 — Пока «четыре», можете лучше!

| Пройти еще раз |

6-7 — Вы отлично усвоили материал!

| Пройти еще раз |

Фото: pixabay. com

com

Корень слова: плавник (корень) | Membean

Латинское корневое слово fin означает «конец», как «граница» или «предел».

Все студенты знают, что экзамен fin al сдается в «конце» курса. Точно так же все те, кто идет на музыкальный концерт, знают, что эль fin знаменует собой «конец» композиции. Когда вы вступаете в гонку, линия fin ish отмечает ее «конец».

То, что имеет размер fin ite, вообще не имеет «конца». Идея позади в fin состоит в том, что для него нет никакого «конца» или «предела»! В то время как в fin ity указывает на непостижимо безграничный размер, что-то, что не имеет «конца» относительно того, насколько маленьким оно может быть, в fin itesimal. Однако когда что-то имеет размер con

Итак, что такое fin ition? Словарь de fin ition отмечает «конец» или «предел» значений, которые имеет данное слово! Если описание чего-либо является неопределенным fin ite, с другой стороны, у него нет видимого «конца» или «границы», и поэтому он неясен.

Давайте продолжим с еще несколькими примерами английской лексики, которые иллюстрируют, что латинский корень слова fin означает «конец». fin или получивший большой «конец», точно так же, как хорошо заточенный карандаш имеет fin e или fin ished point, получив идеальный «конец» 9.0005

Масло re fin ery re fin es или перерабатывает нефть до ее пригодного для использования «конца». Масло re fin eries не будет существовать вечно.

Вы когда-нибудь встречали кого-то, кто действительно разборчив, или действительно плавник неприглядный? fin «границы» неприятного человека слишком fin e, поскольку им очень трудно угодить — нет «конца» fin требования противного человека!

Хорошо, теперь я подведу «конец» к этому обсуждению, так как мы fin ally сделали! Теперь вы будете хорошо подготовлены к fin словам, которые используют fin , точно зная, каковы их «концы» или «пределы»!

- окончательный : относящийся к «концу»

- финал : «конец» чего-то

- отделка : «конец»

- бесконечный : не имеющий «конца» или «предела»

- бесконечность : математическая сущность, не имеющая «конца»

- бесконечно малый : относящийся к чему-то, что не имеет «конца» своей малости

- ограничить : обеспечить тщательную «границу» или «конец», за который нельзя выйти

- определение : «граница» или «конец» значения слова

- неопределенный : не имеющий «конца» или «границы»

- штраф : довести до «хорошего конца»

- нефтеперерабатывающий завод : промышленное предприятие, на котором сырое вещество тщательно перерабатывается до пригодного для использования «конца»

- конечное : качество наличия «конца» чего-то

- привередливый : относится к тому, у кого слишком много «ограничивающих» границ

Композиционное обобщение в семантическом разборе: наборы данных | Денис Луковников | Analytics Vidhya

Если вы скажете человеку, что 🦓 — это зебра, а 🐴 — это лошадь, а затем покажете несколько предложений со словом «лошадь» (например, «Лошадь — это млекопитающее» и «Сколько ног у лошади? ») человек также сможет мгновенно понимать похожие предложения и задавать аналогичные вопросы о лошадях. Это пример способности человека к новым сочетаниям ранее увиденных элементов и конструкций, что называется «композиционным обобщением».

Это пример способности человека к новым сочетаниям ранее увиденных элементов и конструкций, что называется «композиционным обобщением».

Хотя люди считают это само собой разумеющимся, нет уверенности в том, что наши модели НЛП обладают такой же способностью (спойлер: согласно многим документам, перечисленным ниже, у них это получается довольно плохо).

Измерение композиционного обобщения непросто и требует тщательного продумывания дизайна используемых наборов данных и их разбиений на обучение/тестирование. Тем не менее, благодаря некоторым (совсем недавним) замечательным работам, мы наблюдаем больший прогресс в этом вопросе, и, надеюсь, это еще не все.

Ниже мы рассмотрим некоторые существующие наборы данных.

(Lake and Baroni, ICML 2018)

Документ: https://arxiv.org/pdf/1711.00350.pdf

Это одно из первых исследований, указывающее на то, что существующие модели семантического анализа плохо обобщают новые комбинации. уже наблюдаемых элементов. Хотя используемые данные просты, статья указывает на очень интересную проблему современных систем. После публикации эта работа вдохновила на создание нескольких качественных работ, предлагающих различные решения проблемы, которые мы, надеемся, рассмотрим в будущем.

Хотя используемые данные просты, статья указывает на очень интересную проблему современных систем. После публикации эта работа вдохновила на создание нескольких качественных работ, предлагающих различные решения проблемы, которые мы, надеемся, рассмотрим в будущем.

В этой работе создается набор данных, состоящий из последовательностей слов, соединенных с последовательностями простых инструкций (например, JUMP). Входные последовательности генерируются с использованием простой CFG, а соответствующие выходные последовательности генерируются с использованием простых правил. В SCAN есть примитивных команд (например, LTURN, JUMP), а также модификаторы и союзы, которые помогают композиционно построить последовательность действий. Пример задачи дается парой

- ( «дважды повернуть налево» , LTURN LTURN).

Итак, задача состоит в том, чтобы сопоставить последовательность «естественного языка» с последовательностью инструкций.

Авторы экспериментируют с различными архитектурами seq2seq на основе RNN, с вниманием и без внимания.

Было проведено три эксперимента с данными SCAN.

Во-первых, случайное разбиение доступных данных дает точность >99%. Высокая точность теста по-прежнему была достигнута с использованием лишь небольшой части обучающих примеров.

Затем авторы проверили, могут ли модели обобщаться до более длинных последовательностей . Примеры с самыми короткими последовательностями действий (выходами) использовались при обучении, а самые длинные — при тестировании. Все модели на этом сплите блестяще провалились (достигнув точности 20,8% 😮) и решили только тестовые примеры с кратчайшими последовательностями действий.

Наконец, авторы также экспериментируют с , «экстраполируя» примитив . Настройка такова, что определенная команда видится только как примитивный пример (например, «прыжок» → ПРЫЖОК) во время тренировки, в то время как все остальные команды видны в составных командах. В частности, тестировались только «повернуть налево» и «прыгнуть» , поскольку остальные варианты эквивалентны. Эксперименты показали, что вариант «повернуть налево» по-прежнему дает хорошие результаты (~ 90%), в то время как вариант «прыжок» полностью проваливается (~ 1% 🙊). Это различие объясняется тем, что если команда «повернуть налево» наблюдалась только изолированно (все остальные обучающие примеры не содержали этой команды во входных данных), то соответствующее ей действие LTURN наблюдалось при обучении в составе других команды (например, «иди налево и прыгни налево» ). В версии «прыжок» соответствующая команда JUMP при обучении вообще не наблюдалась.

Эксперименты показали, что вариант «повернуть налево» по-прежнему дает хорошие результаты (~ 90%), в то время как вариант «прыжок» полностью проваливается (~ 1% 🙊). Это различие объясняется тем, что если команда «повернуть налево» наблюдалась только изолированно (все остальные обучающие примеры не содержали этой команды во входных данных), то соответствующее ей действие LTURN наблюдалось при обучении в составе других команды (например, «иди налево и прыгни налево» ). В версии «прыжок» соответствующая команда JUMP при обучении вообще не наблюдалась.

Несмотря на то, что модель знала, что «прыгать» → ПРЫГАТЬ и понимала различные выражения с другими действиями (например, « идти и повернуть направо» ), модель не могла понять «прыгать» в этих контекстах ( например, « прыгнуть и повернуть направо» ).

(Финеган-Доллак, ACL 2018)

Документ: https://arxiv. org/pdf/1806.09029.pdf

org/pdf/1806.09029.pdf

В этой работе авторы сосредотачиваются на (1) сложности запросов, утверждая, что человеческие вопросы требуют более сложных запросов, чем те, которые используются в автоматически генерируемых наборах данных, и (2 ) разделение обучения/тестирования, где авторы утверждают, что стандартные разделения на самом деле не требуют обучения для создания новых шаблонов запросов.

При анализе наборов данных Text2SQL они обнаружили, что некоторые часто используемые имеют ограниченное количество шаблонов и что большие наборы данных не обязательно имеют пропорционально больше шаблонов запросов. Чтобы дополнительно изучить эффект, который это имеет, авторы пробуют простой подход на основе шаблонов, который автоматически идентифицирует шаблоны из обучающих данных, а во время теста назначает пример одного из этих шаблонов и заполняет его слоты. Эта базовая линия на основе шаблона достигает конкурентоспособной производительности с моделями seq2seq для нескольких наборов данных. Это вызывает беспокойство, потому что базовый план на основе шаблона не может обобщаться на новые шаблоны запросов по своей конструкции. Тем не менее, авторы обнаруживают, что seq2seq действительно демонстрирует некоторую способность обобщать за пределы шаблонов, наблюдаемых во время обучения.

Это вызывает беспокойство, потому что базовый план на основе шаблона не может обобщаться на новые шаблоны запросов по своей конструкции. Тем не менее, авторы обнаруживают, что seq2seq действительно демонстрирует некоторую способность обобщать за пределы шаблонов, наблюдаемых во время обучения.

Авторы также экспериментируют с другим разделением поезд/тест. Там, где обычно данные разбиваются таким образом, чтобы в тесте не встречалась пара (вопрос, запрос), которая использовалась при обучении, авторы предлагают разделение на основе чисто шаблона запроса . Чтобы создать это разделение, они сначала анонимизируют сущности в запросах SQL и позволяют примерам с одним и тем же анонимным запросом быть только в обучении или тестировании. Это разделение оказалось гораздо более сложным для нескольких часто используемых наборов данных Text2SQL, что часто приводило к резкому снижению производительности. Это еще раз указывает на зависимость существующих моделей от запоминания шаблонов запросов.

Таким образом, эта работа показывает, что обычно используемая методология оценки для семантического разбора может игнорировать композиционную способность моделей к обобщению, которая в значительной степени может быть сведена к модели заполнения слотов.

(Keysers et al., ICLR 2020)

Статья: https://openreview.net/pdf?id=SygcCnNKwr

Состав атомарных и составных фраз. Источник. В то время как работа над SCAN предоставила первоначальные доказательства неспособности стандартных моделей seq2seq обобщать невидимые композиции, установка в SCAN была чрезвычайно простой, а в данных использовалась лишь наноскопическая часть языка. В этой работе авторы нацелены на более интересную универсальную настройку семантического анализа для ответов на вопросы по графам знаний. И пока СКАН тестировал «повернуть налево» и «прыгнуть» , эта работа следует более систематическому подходу, который генерирует расщепления на основе максимального расхождения соединений при минимизации расхождения атомов.

Оценка композиционности на основе распределения

Основная идея этой работы состоит в том, чтобы создать набор данных/контрольный показатель с разделением обучения/тестирования, который минимизирует перекрытие между соединениями, наблюдаемыми во время обучения, и теми, которые наблюдаются во время тестирования, и в то же время гарантирует, что все компоненты (атомы) для построения этих составных фраз во время теста наблюдались во время обучения.

Атомарные фразы можно рассматривать как те фразы, значение которых нельзя далее разделить на состав некоторых составляющих элементов. Например, слово «лошадь» напрямую относится к животному 🐴 и не подлежит дальнейшему разложению. Другие фразы, такие как «возраст» (со ссылкой на предикат age(X, Y) ) и шаблоны вопросов (например, «Что такое <предикат> <сущности>» ) также считаются атомами. . Напротив, соединения — это фразы, из которых состоят эти атомы. Например, «Сколько лет лошади» составляет все три вышеуказанных атома.

Чтобы проверить композиционное обобщение моделей seq2seq, расщепления тестовой последовательности определяются таким образом, чтобы расхождение между распределениями атомов было минимальным, а расхождение между распределениями композиционных фраз (составное расхождение) должно быть максимальным. Когда все атомы были обнаружены во время обучения, система не страдает от проблем со словарным запасом, которые привели бы к очевидным потерям производительности. Однако минимизация количества общих соединений между тестом и обучением проверяет модель на ее способность составлять уже наблюдаемые атомы новыми, ненаблюдаемыми способами.

Набор данных

Авторы создают большой набор данных семантического синтаксического анализа на основе Freebase и предоставляют три различных разделения обучающих тестов, которые максимизируют составное расхождение при минимизации атомарного расхождения. Набор данных формируется автоматически, но, судя по примерам, вопросы выглядят вполне естественно.

По стандартам семантического разбора набор данных очень велик: 239 357 вопросов, 228 149 запросов и 34 921 шаблон запросов. И ввод, и вывод предоставляются в разных форматах, где объекты упоминаются по их имени, идентификатору или просто заполнителю. Это означает, что вам не нужно беспокоиться о запуске сущностей, связывающих ¯\_(ツ)_/¯.

Вопросы на английском языке:

- «Агустин Альмодовар был исполнительным продюсером Deadfall»

Также предоставляются различные варианты входных вопросов, например, с использованием заполнителей для сущностей:

- 9014 5 «Исполнительный продюсер M0 M1»

И запросы приведены в SPARQL:

- «SELECT count(*) WHERE {ns:m.04lhs01 ns:film.producer.films_executive_produced ns: m.0gx0plf}»

Также приведены версии-заполнители запросов SPARQL:

- «SELECT count(*) WHERE {M0 ns:film.producer. Films_executive_produced M1}”

При проведении экспериментов авторы используют версии, в которых сущности заменены заполнителями.

Набор данных создается автоматически с использованием набора правил. Во-первых, генерируется вопрос на естественном языке и соответствующая ему логическая форма. Затем логическая форма сопоставляется с запросом SPARQL. Логическая форма использует вариант логики описания ℰℒ (ℰℒ DL допускает только пересечения и кванторы существования). Приложения правил образуют DAG, а подграфы этого DAG, соответствующие соединениям, используются для измерения составного расхождения.

Эксперименты

Авторы проводят эксперименты по CFQ, а также по SCAN с тремя моделями: LSTM+Attention, Transformer и Universal Transformer. При использовании случайного разбиения, что обычно и делается, все три модели достигают очень высокой производительности (выше 95%). Однако, когда модели обучаются с использованием расщеплений MCD, результаты резко падают ниже 20%!!! 😮

Результаты теста с бумаги. Авторы приходят к выводу, что нормальные модели, которые обычно повсеместно используются для семантического разбора, на самом деле совсем плохи, когда видят новые комбинации уже виденных вещей.

Можно утверждать, что эти результаты являются ожидаемыми, поскольку распределения обучающих и тестовых данных резко различаются, и что модель даже не должна обрабатывать такое несоответствие.

С другой стороны, это не должно иметь значения, поскольку нам нужны семантические парсеры, способные создавать новые комбинации элементов.

(Shaw et al., 2020)

Документ: https://arxiv.org/pdf/2010.12725.pdf

В то время как критерий MCD CFQ обеспечивает хорошо обоснованное разделение, метод разделения CFQ полагается на входные и выходные данные, генерируемые набором правил. Это ограничивает применимость их критерия MCD только к синтетическим данным. В этой работе Shaw и соавт. предложить простую адаптацию MCD, которая вычисляет составную дивергенцию, используя только целевые представления (логические формы). Это позволяет находить расщепления TMCD также для уже существующих, созданных вручную примеров без каких-либо дополнительных аннотаций.

Этот показатель можно использовать для разделения существующих наборов данных (здесь используются GeoQuery и Spider). Авторы создают разделения, которые максимизируют TMCD, обеспечивая при этом, чтобы все атомы наблюдались хотя бы один раз во время обучения.

Для набора данных GeoQuery авторы используют версию FunQL и принимают все символы предикатов и сущностей как атомы. Составные — это комбинации родительских и дочерних символов в дереве FunQL. Обратите внимание, что соединения не обязательно должны быть полными (под)деревьями. Для SQL авторы берут отдельные токены как атомы и определяют составные части на основе разбора запросов CFG.

Дополнительный момент, на который обращают внимание авторы, заключается в том, что многие работы, посвященные композиционному обобщению, были оценены только с помощью SCAN и что их производительность на существующих стандартных наборах данных семантического анализа (таких как GeoQuery) может быть ниже номинала из-за компромиссов, сделанных для улучшения композиционное обобщение.

Наконец, авторы предлагают подход к семантическому анализу, в котором используется предварительно обученный преобразователь T5 seq2seq, а также автоматически индуцированный семантический анализатор на основе грамматики, о котором мы расскажем в следующей статье.

(Ким и Линзен, EMNLP 2020)

Документ: https://arxiv.org/pdf/2010.05465.pdf

Здесь авторы создают набор данных семантического анализа, который позволяет явно измерить пять лингвистически мотивированных типов обобщения. Это отличается от CFQ, который просто максимизирует сложное расхождение. Хотя COGS охватывает некоторые случаи (обобщение примитивов), использованные в предыдущих работах, диапазон категорий более широк.

Набор данных содержит предложения, соединенные с лямбда-выражениями. Предложения генерируются автоматически с использованием PCFG.

В наборе данных содержатся следующие категории обобщения:

1. Обобщение примитивов и других грамматических ролей:

Здесь есть два типа примеров:

a). обучение только примитивам (атомам) и тестирование предложений, содержащих эти примитивы. Нарицательные существительные сопоставляются с унарными предикатами (например, «лошадь» → λx.horse(x) ), имена собственные сопоставляются с константами (например, «Rocinante» → ROCINANTE ), а глаголы сопоставляются с n-арными предикатами (пример из статьи: «like» → λx.λy.λe.like.agent(e,y) ∧ like.theme (е, х) ).

обучение только примитивам (атомам) и тестирование предложений, содержащих эти примитивы. Нарицательные существительные сопоставляются с унарными предикатами (например, «лошадь» → λx.horse(x) ), имена собственные сопоставляются с константами (например, «Rocinante» → ROCINANTE ), а глаголы сопоставляются с n-арными предикатами (пример из статьи: «like» → λx.λy.λe.like.agent(e,y) ∧ like.theme (е, х) ).

Такие изолированные сопоставления наблюдаются только во время обучения. Во время тестирования эти примитивы используются в полном предложении вместе с другими константами и предикатами.

Обратите внимание, что это очень похоже на третий эксперимент SCAN, где проверяется обобщение примитивов, видимых только изолированно.

б). замена слова с дополнения на субъект. Например, если во время тренировки наблюдается «лошадь съела морковь» (здесь речь идет об испытуемом «лошадь» ), то в тестовой выборке не будет примеров, где «лошадь» используется в качестве подлежащее, но будет пример, где «лошадь» используется как прямое дополнение (например, «Дон Кихот ехал на лошади» ).

2. Модифицированные словосочетания в другой синтаксической роли

Когда, например, именная группа (NP) изменяется с предложной группой (PP), мы получаем новую NP, которая может использоваться в тех же синтаксических ролях, что и исходная NP. Например, [the horse](NP) и [[the horse][on field]] (NP, состоящее из NP и PP), оба могут использоваться в предложении как дополнение или подлежащее.

Во время обучения COGS использует предложения с PP-модифицированными NP в качестве объекта, а во время тестирования PP-модифицированные NP используются в качестве роли субъекта.

3. Более глубокая рекурсия

Человеческий язык позволяет вкладывать фразы в другие фразы, что позволяет строить бесконечное количество выражений. Например, предложение может иметь один уровень вложенности: «Дон Кихот знал, что Росинант ел траву» , но это может быть и более глубокая: «Дон Кихот знал, что Санчо Панса знал, что Росинант ел траву» .

В COGS при обучении используется только до двух уровней вложенности, а в тестовых примерах этой категории используется строго три и более уровней. Это позволяет измерить способность моделей экстраполировать на более длинные предложения с определенными типами рекурсии. Обратите внимание, что это чем-то похоже на второй эксперимент SCAN, где в обучении использовались более короткие последовательности, а затем модель тестировалась на более длинных.

4. Чередование глаголов

Некоторые глаголы, которые могут употребляться в переходной форме ( «Дон Кихот накормил лошадь» ), также могут употребляться в пассивной форме ( «Лошадь накормили» ). Этот и другие шаблоны включены в набор данных COGS: конкретный глагол используется только одним способом (например, активным) в обучающем наборе, в то время как используется только другим способом (например, пассивным) в тестовом наборе.

5. Класс глаголов

Прежде чем обсуждать последний, давайте возьмем…

Небольшой экскурс в глаголы и семантику:

Некоторые более лингвистически подкованные читатели, вероятно, уже знают это и могут уверенно пропустить это.

Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория.

Глаголы могут быть переходными , что означает, что у глагола есть подлежащее и дополнение (например, «Росинант [subj]🐴 съел траву [obj]🌿» ). Но глаголы также могут быть непереходными , что означает, что у них нет объекта (например, «Росинант [subj] съел» ).

Теперь давайте повторим семантические роли. Субъект и объект — это грамматические роли, и хотя они обычно коррелируют с нашим пониманием того, кто что с кем делает, они не всегда правильны. Чтобы правильно описать, что кто-то кому делает, что было бы буквальным «значением» описываемого действия, мы можем лучше использовать семантические роли. Кроме того, семантические роли также предоставляют более точную информацию о последствиях действия.

Основные семантические роли (также известные как тематические отношения) здесь нас больше всего интересуют (1) Агент 901 45 , (2) Тема и (3 ) Пациент , хотя есть несколько других, которые покрывают свой собственный кусок семантического пирога.

Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ).

Вернемся к глаголам. Среди непереходных глаголов есть неэргативные глаголы и неаккузативные глаголы. Неэргативный Глаголы — это глаголы, грамматический субъект которых также является его семантическим агентом (например, «Росинант съел» ) и невинительные глаголы — это глаголы, субъект которых является пациентом или темой, поэтому субъект сам страдает от действия (например, «Росинант исчез». ).

Для последней категории «Класс глаголов» авторы отмечают, что грамматических ролей недостаточно для предсказания правильной структуры аргумента. Например, хотя как неэргативный, так и неаккузативный глагол кажутся синтаксически непереходными, подлежащее глагола в первом случае является Агентом, а во втором случае Темой или Пациентом, что также будет отражено в построенной логической форме.

Например, хотя как неэргативный, так и неаккузативный глагол кажутся синтаксически непереходными, подлежащее глагола в первом случае является Агентом, а во втором случае Темой или Пациентом, что также будет отражено в построенной логической форме.

Для проверки способности моделей семантического разбора к обобщению авторы включают случаи, когда определенный NP встречается только в одной роли при обучении и в другой при тестировании. Например, определенный NP наблюдается как субъект-агент (например, «Росинант» в «Росинант ел траву» ), но в наборе обобщения встречается как тематический субъект (например, «Росинант исчез 👻 .” )

Набор данных

Набор данных автоматически генерируется с использованием PCFG, и каждое предложение на естественном языке проходит этап автоматической обработки для создания логических форм.

Пример пары вопрос-логическая форма:

- «Кошка улыбнулась» → кот(х) ∧ улыбка.

агент(у, х)

агент(у, х)

Наборы для обучения, разработки и тестирования содержат 24155, 3000 и 3000 экземпляров соответственно. Последние 155 примеров в обучающем наборе являются примитивами. Набор обобщений, который является тестовым набором, используемым для измерения композиционного обобщения, был создан с использованием другой PCFG и содержит 21000 примеров.

Результаты

Модели seq2seq на основе Transformer и LSTM были протестированы в экспериментах.

Как и ожидалось, результаты случайного тестирования (с использованием тестового набора из 3000 примеров) были близки к идеальным.

Однако производительность на наборе обобщений (набор тестов из 21 тыс. примеров, содержащих сложные случаи) была в среднем довольно низкой, с разными числами для разных случаев обобщения и высокой дисперсией между запусками. В целом, стандартные модели seq2seq сильно потерпели неудачу:

Авторы также провели анализ ошибок, сравнив лексический и структурный обобщение.

Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория.

Для остальных вот небольшой обзор терминологии, чтобы помочь понять, что представляет собой эта пятая категория.  Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ).

Агент — это сущность в предложении, которая выполняет действие (например, «Росинант [Агент] ел траву». ). Роли «Тема» и «Пациент» являются получателями выполняемого действия, с той разницей, что состояние «Пациент» изменяется (например, «Росинант съел траву [Пациент]» ), а Тема — нет (например, «Росинант любит траву [Тема]»). ).  агент(у, х)

агент(у, х)